背景:

早期服务器集中于腾讯云,开始是传统网络。后面是自定义的私有网络vpc.当然了vpc中还有容器网络,容器的网络方案使用了默认的Global Router,并没有使用VPC-CNI的容器网络与云主机网络在同一个 VPC 内的方案(腾讯云官方文档还有了Cilium-Overlay 的方案,恩还有个测试环境的k8s集群是kubeadm自建的集群网络插件用的cilum).今年45月份有些新业务又跑在了某云上面,集群环境直接用了某云的ACK PRO。网络插件使用了Flannel ,也没有使用某云的Terway。现在的需求就是要把两个网络打通!

看了一下网上的各种方案:

我也选择了WireGuard的方案…..

以下测试都基于新环境搭建,没有敢在现有的环境去搞……

终极实现目标

三个vpc

就先以ABC命名吧 !A B 网络双向互通,c网络可以连接b,A网络可以连接C?初步规划每个集群起码有2台服务器以上,可以ping通ssh目标网络服务器?恩 还可以在每个网络k8s集群中搞一个nginx service,用curl掉一下测试应用的访问?初步就算那么想的!

注:所谓互通都包括容器网络的通信!

还是依赖与这个神奇的工具:http://www.ab126.com/web/3552.html,还是拿10.0.0.0/8去分了。A网络腾讯云上海vpc网络设置为10.10.0.0/16, B网络某云网络10.20.0.0/16,C网络腾讯云北京VPC10.40.0.0/21

注意:创建子网subnet的时候手残了,没有注意本来wireguard-shanghai3对应上海三区,wireguard-shanghai4对应上海四区的,没有留意,就做成这样的了……

某云B网络创建VPC也创建了4个可用区。但是他的定义都是叫什么交换机!,如下:

注意:当然了B网络也选择了上海区域,与腾讯云A网络处于同一地区!

觉得A,B网络浪费资源了….就修改了一下子网掩码:

最终网段规划为10.40.0.0/21

subset子网如下:

A网络容器网络CIDR172.16.0.0/16,Service CIDR172.16.252.0/22(其实就是172.16.0.0/16)

恩 觉得容器网络 /16整段也有点浪费,修改一下就取172.17.0.0/20吧,本来就是演示的这些资源也都够用了,实际生产环境中,如果需要考虑多地域,or多集群,还考虑互通,应该合理划分子网资源!

由于某云容器服务需要填写Pod CIDR Service CIDR开始本来想直接分两个网段的但是操作失误删除了集群重建冲突了(开始用的某云自己的那操作系统,安装wireguard不顺畅,删除更换系统为centos7了!),就把172.17.0.0/20划分了四个子网取Pod CIDR172.17.8.0/22 Service CIDR172.17.12.0/22

以网络c为例:容器网络依然从172.17.0.0/16子网20去分吧!选择了172.17.16.0/20段

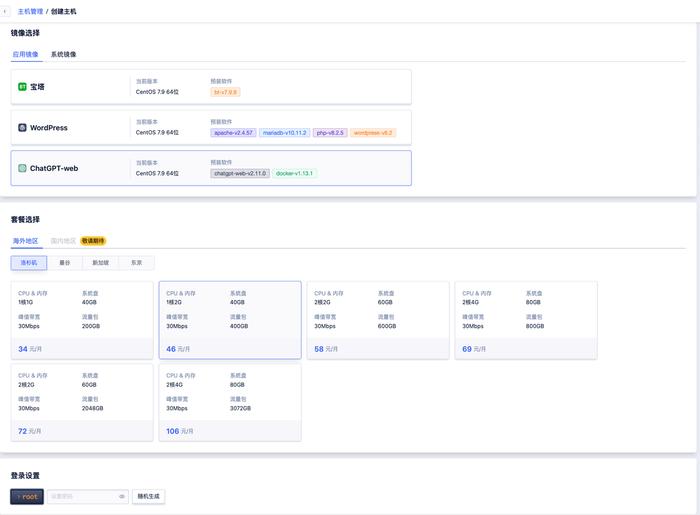

创建tke集群可以参考下图:

打开tke控制台,选择区域北京,新建:

输入集群名称(个人定义了),关键是集群网络选择前面创建的C网络(北京有好几个vpc网络呢),配置容器网络172.17.16.0/20

比较喜欢TKE容器网络的设置好带能搞在一个段里……某云的还要算一下。比较麻烦了,系统选择了ubuntu20.04,也不去用腾讯云自己的TencentOS Server了,怕跟某云的系统一样安装wireguard有问题(其实可以参考非标准内核的安装方式,懒得看了)……

下一步,特意添加了两台cvm且不在同一个subset:

默认下一步吧选择自己的登陆方式,我这里选择了自己的ssh-key方式!

可选组件就直接默认了,毕竟我这里主要是演示wireguard组网!下一步:

同意,完成等待创建ing……

c集群 两台server 10.40.2.6将安装wireguard,10.40.3.14后续作测试。

wireguard的安装

注:某云ack操作系统智能选择centos7与alios 某云系统内核不是标准内核故操作系统我使用的centos7,腾讯云tke集群我用的是ubuntu 20.4系统!

每个个集群都初始保证两台server以上

vpc网络资源10.10.0.0/16

容器网络资源:172.16.0.0/16

vpc网络资源10.20.0.0/16

容器网络资源:Pod CIDR172.17.8.0/22 Service CIDR172.17.12.0/22(17.17.0.0/20)

vpc网络资源10.40.0.0/21

容器网络资源:Pod CIDR172.17.16.0/20 Service CIDR172.17.28.0/22

防火墙都是关闭的,代理服务器(安装wireguard节点)开启了ip转发

保证net.ipv4.ip_forward = 1

初步选择在10.10.4.8这台cvm安装wireguard

注:由于A C都是tke,且系统相同,我的安装演示都是在10.40.2.16节点上!主要是开始操作的时候没有截图……

内核5.4

检查下 wireguard 模块是否已经加载,如果没有加载,试下执行 modprobe wireguard加载模块

B网络服务器系统为centos7故yum操作安装wireguard:

注:关于内核是否升级看个人意愿。或者找一个额外机器升级….为了维护集群稳定性,未能升级内核

A B网络互通

基本就是实现下图这样B网络中容器and vpc网络通过cvm 10.20.4.42的公网ip 到A网络10.10.4.8的公网Ip 路由访问A网络中资源,反之A网络容器and vpc网络资源通过10.10.4.8的公网ip到B网络的10.20.4.42的公网ip路由访问B网络中资源(自己的理解,可能语言表达有误)

注意:10.30.0.1/24 10.10.30.2/24为wareguard网络,避免与各个网络地址冲突!

- Interface

Address:这个是开启wg之后本机的隧道IP

ListenPort:这个就设置51820了忘了看了哪个文章的了

PrivateKey:本机的私钥/etc/wireguard/keys/vpn-gw.key

- Peer

Public Key: 服务端(就是要连接的网络的有公网ip,安装wireguard的节点)的公钥即需要连接的对方10.20.4.42的/etc/wireguard/keys/vpn-gw.pub

Allow IPs: 需要走隧道的IP段, 一般包含隧道自身IP段, 以及要借道隧道的IP段, 但是这里设置并不会产生对应的route

Endpoint: 服务端的IP和端口

Persis.Keepalive: 25 保持活动的时间间隔

10.10.4.8节点wg0.conf配置

cat /etc/wireguard/ wg0.conf

10.20.4.42节点wg0.conf配置

cat /etc/wireguard/ wg0.conf

注: 10.20.4.42 10.10.4.8都启动服务,关闭服务down只是演示,保持服务up启动!

同理关闭服务就是:

10.10.4.8 ping 10.20.4.42

如何ping 通vpc内其他cvm等网络资源呢?

登陆腾讯云后台私有网络控制台找到对应vpc路由表,添加到B网络的路由(关于172.17.0.0/16网段并没有与B完全匹配…..C网络的容器网络我也会路由到这里就先这样写了)

同理,某云后台,打开路由表

将下一条指定到服务器i-uf6fxoj4zcqlpe8jupv2即10.20.4.42节点

从A网络开始开始:

10.10.4.17 ping 10.20.4.42 10.20.4.43

换一个subset:

10.10.2.4 ping 10.20.4.42 10.20.4.43

可以在A集群10.10.4.8 tcpdump看一下icmp包的抓包:

反之B网络测试:

10.20.4.43 ping 10.10.4.8 10.10.4.17 10.10.2.4

A网络run 一个nginx deployment 并开启service:

没有开启内网访问,开启一下吧,否则都没有办法用kubectl,将生成文件内容copy到A集群任一节点用户家目录下./kube/config文件中(当然了可以不开启,直接控制台操作)

可以kubectl run or 控制台创建一个nginx镜像就好 主要是创建一个service:

- B网络服务器pingA网络 nginx pod service ip

- B 网络服务器curl nginx pod service ip

注意:可以随便找个带ping curl的镜像,这个镜像我是用习惯了

- B网络集群中pod ping A网络vpc cvm地址

- B集网络集群pod ping A网络集群 中nginx pod service

- B集网络集群pod curl A网络集群 中nginx pod service

B网络创建nginx deployment svc

- 同理A 网络cvm ping B网络容器集群nginx pod svc ip

- 同理curl 测试

curl就拿一台cvm测试了。。。。。

ping 容器网络

C连接B连通性测试

由图中关系可见需要在10.20.4.42节点允许10.30.0.3/24的通信

en 登陆另外一节点10.40.3.16 ping B集群节点不通?

恩 依然是路由的问题,找到vpc 路由表,添加路由

curl就稍微看一眼了

测试一下就好了….不通就是对的

A连接C连通性测试

wg-quick重启wg0服务

前面没有说特意拿C网络来说一下。防火墙要开通UDP:51820(或者着针对自己的ip地址),前面AB集群我都默认打开了。不开通的时候是ping 不通的,打开tcp:51820依然不通,打开udp:51820就可以ping 通了!

A网络其他cvm ping C网络一定记得手动添加路由:

草草测试一下吧吧……

问题来了:

上面 A B CB AC的测试再作一遍发现….AB不通了:

看一眼AB 节点的配置文件

A集群

B集群

初步怀疑两个集群配置文件里面有冲突了?过程就是一次次改尝试

A集群10.0.4.8节点

B集群10.20.4.42节点

C集群10.40.2.16节点

重复一遍各种Ping curl测试通过!

总结:

原文链接:https://cloud.tencent.com/developer/article/2081296